알리바바(Alibaba)의 Qwen 팀이 새로운 오픈 소스 AI 모델 시리즈인 Qwen3를 공식 출시했다는 소식입니다. 이 모델은 오픈 소스 모델 중 최고 수준의 성능을 보여주며, 오픈AI(OpenAI)나 구글(Google) 같은 기업의 독점 모델 성능에 근접한다고 합니다.

Qwen3 시리즈, 다양한 모델 라인업

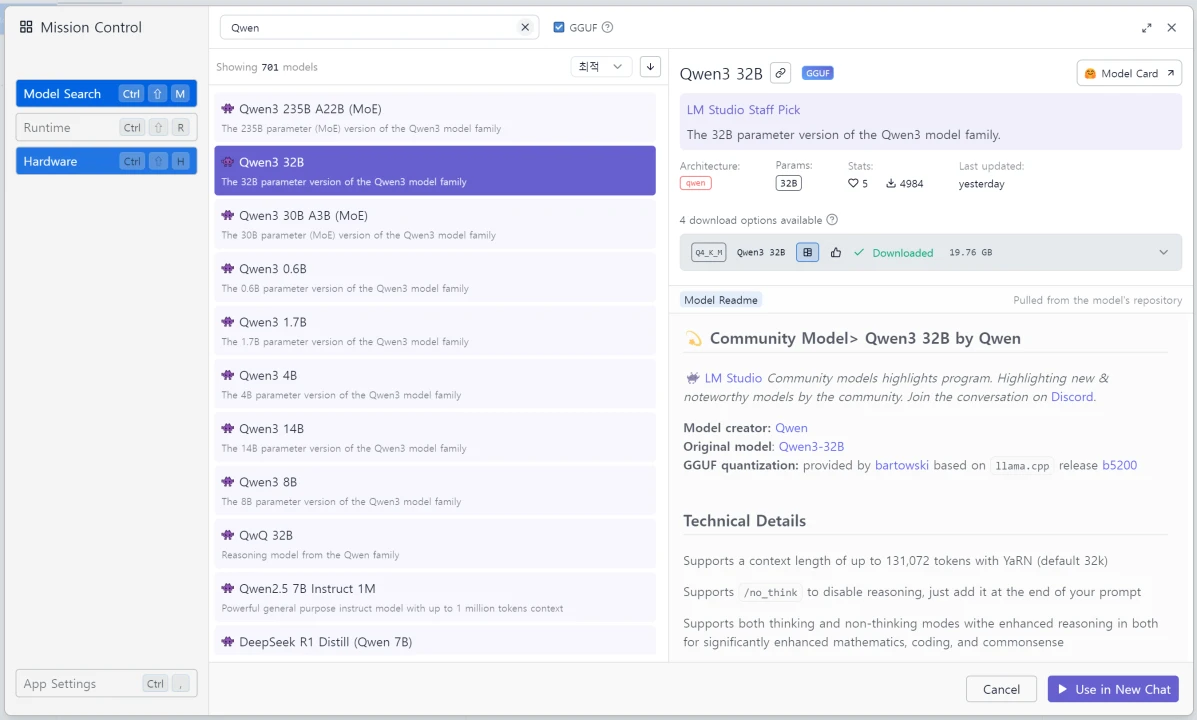

Qwen3 시리즈는 총 8개의 모델로 구성되어 있어요. ‘Mixture-of-Experts (MoE)’ 모델 2개와 ‘Dense’ 모델 6개가 포함됩니다. MoE 방식은 여러 전문 모델을 결합하여 필요한 부분만 활성화하는 것으로, 오픈 소스 AI 스타트업인 미스트랄(Mistral)이 대중화한 방식이라고 하네요.

벤치마크에서 보여준 뛰어난 성능

Qwen 팀에 따르면, 2350억 개의 매개변수를 가진 Qwen3 모델(코드명 A22B)은 소프트웨어 엔지니어링 및 수학 분야 500개 질문으로 구성된 ArenaHard 등 주요 제3자 벤치마크에서 딥시크(DeepSeek)의 오픈 소스 R1 모델과 오픈AI의 독점 모델 o1을 능가하는 성능을 보였습니다. 또한, 구글의 새로운 독점 모델인 제미나이 2.5-프로(Gemini 2.5-Pro)의 성능에도 근접했다고 해요. 전반적으로 Qwen3-235B-A22B는 현재 공개된 모델 중 가장 강력한 모델 중 하나로 평가받고 있습니다.

하이브리드 추론 기능 탑재

Qwen3 모델은 ‘하이브리드 추론’ 또는 ‘동적 추론’ 기능을 제공하도록 훈련되었습니다. 사용자는 빠르고 정확한 응답과 더 많은 시간과 컴퓨팅 자원을 소모하는 추론 단계를 필요에 따라 전환할 수 있습니다. 이는 과학, 수학, 엔지니어링 등 전문 분야의 어려운 질문에 유용하며, 오픈AI의 ‘o’ 시리즈나 누스 리서치(Nous Research) 같은 스타트업들이 개척한 접근 방식입니다. Qwen Chat 웹사이트의 ‘Thinking Mode’ 버튼을 사용하거나, 로컬 또는 API 배포 시 /think 또는 /no_think 같은 특정 프롬프트를 삽입하여 이 기능을 활용할 수 있습니다.

폭넓은 접근성과 오픈 소스 라이선스

이 모델들은 현재 허깅 페이스(Hugging Face), 모델스코프(ModelScope), 캐글(Kaggle), 깃허브(GitHub) 등 다양한 플랫폼에서 접근하고 배포할 수 있습니다. 또한, Qwen Chat 웹 인터페이스 및 모바일 앱을 통해서도 직접 상호작용할 수 있어요. MoE 모델과 Dense 모델 모두 아파치 2.0(Apache 2.0) 오픈 소스 라이선스 하에 제공됩니다. 이 라이선스는 상업적 사용을 포함한 광범위한 사용을 허용합니다. Dense 모델로는 Qwen3-32B, 14B, 8B, 4B, 1.7B, 0.6B 등 다양한 크기의 모델이 제공되어 사용자의 필요와 컴퓨팅 환경에 맞춰 선택할 수 있습니다.

향상된 훈련과 다국어 지원

Qwen3는 이전 모델인 Qwen2.5에 비해 훈련 데이터셋 규모가 약 36조 토큰으로 두 배 증가했습니다. 데이터 소스는 웹 크롤링, PDF 문서 추출, 그리고 이전 Qwen 모델을 사용하여 생성된 수학 및 코딩 관련 합성 데이터 등을 포함합니다. 훈련 파이프라인은 3단계의 사전 훈련과 4단계의 후처리 개선 과정을 거쳐 하이브리드 추론 기능을 구현했습니다. 이러한 훈련 개선 덕분에 Qwen3의 Dense 기본 모델은 Qwen2.5의 훨씬 큰 모델과 동등하거나 그 이상의 성능을 발휘합니다. 또한, Qwen3 모델은 다국어 지원을 크게 확장하여 이제 119개의 언어와 방언을 지원합니다. 이는 전 세계 다양한 언어 환경에서 모델의 잠재적 응용 범위를 넓혀줍니다.

다양한 배포 옵션

Qwen3 모델은 SGLang 및 vLLM과 같은 프레임워크를 사용하여 통합할 수 있으며, 이들 모두 OpenAI 호환 엔드포인트를 제공합니다. 로컬 사용을 위해서는 Ollama, LMStudio, MLX, llama.cpp, KTransformers 등이 권장됩니다. 모델의 에이전트 기능을 활용하려는 사용자는 Qwen-Agent 툴킷을 탐색해 볼 수 있습니다.

기업 의사결정자에게 미치는 영향

엔지니어링 팀은 기존 OpenAI 호환 엔드포인트를 새로운 모델로 몇 시간 안에 전환할 수 있습니다. MoE 모델(235B 매개변수 중 22B 활성, 30B 중 3B 활성)은 20-30B Dense 모델과 유사한 GPU 메모리 비용으로 GPT-4 수준의 추론 성능을 제공합니다. 공식 LoRA 및 QLoRA 훅을 통해 독점 데이터를 외부 업체에 보내지 않고도 비공개 미세 조정을 할 수 있습니다. 0.6B부터 32B까지 다양한 Dense 모델은 노트북에서 프로토타이핑하고 멀티 GPU 클러스터로 확장하기 쉽게 해줍니다. 가중치를 온프레미스에서 실행하면 모든 프롬프트와 출력을 기록하고 검사할 수 있으며, MoE 희소성은 호출당 활성 매개변수 수를 줄여 추론 공격 표면을 감소시킵니다. 아파치 2.0 라이선스는 사용 기반 법적 장애물을 제거하지만, 중국 기반 공급업체가 훈련한 모델 사용에 대한 수출 통제 및 거버넌스 영향을 검토해야 합니다. 이는 딥시크, 텐센트(Tencent), 바이트댄스(ByteDance) 등 다른 중국 기업뿐만 아니라 오픈AI, 구글, 마이크로소프트(Microsoft), 앤트로픽(Anthropic), 아마존(Amazon), 메타(Meta) 등 북미 기업들에게도 실행 가능한 대안을 제공합니다. 특히 메타의 라이선스보다 더 관대한 아파치 2.0 라이선스는 큰 장점입니다. 이는 AI 제공업체 간의 경쟁이 매우 치열하며, 비용 절감을 모색하는 기업들은 새로운 모델을 유연하게 평가해야 함을 시사합니다.

앞으로의 전망

Qwen 팀은 Qwen3를 점진적인 개선을 넘어 인공 일반 지능(AGI) 및 인공 초지능(ASI)을 향한 중요한 단계로 보고 있습니다. 다음 단계 계획에는 데이터 및 모델 크기 추가 확장, 컨텍스트 길이 연장, 모달리티 지원 확대, 환경 피드백 메커니즘을 통한 강화 학습 강화 등이 포함됩니다. 대규모 AI 연구 환경이 계속 발전함에 따라, 접근 가능한 라이선스 하에 Qwen3의 오픈 웨이트 출시는 또 다른 중요한 이정표를 세우며, 최첨단 LLM으로 혁신하려는 연구자, 개발자, 조직의 장벽을 낮추고 있습니다.