딥시크(DeepSeek), 엔비디아(Nvidia) NIM 마이크로서비스로 통합

최근 몇 주 동안 AI 업계를 강타한 딥시크가 고급 추론 모델의 접근성을 확대하는 데 상당한 진전을 이루었어요.

딥시크는 자사의 주력 모델인 딥시크 R1 모델을 엔비디아, AWS, 깃허브(GitHub)를 포함한 여러 플랫폼에서 사용할 수 있다고 발표했어요.

딥시크의 특성상 개발자들은 딥시크 아키텍처를 기반으로 모델을 구축할 수 있으며, 현재 협업 AI 모델 개발 플랫폼에는 3,374개의 딥시크 기반 모델이 있다고 해요.

엔비디아, AWS, 깃허브 및 애저(Azure)에서 딥시크를 제공

AWS에서는 API 통합을 간소화하는 아마존 베드락(Amazon Bedrock)과 고급 사용자 정의 및 학습을 가능하게 하는 아마존 세이지메이커(Amazon SageMaker)를 통해 딥시크를 지원하며, 최적화된 비용 효율성을 위해 AWS 트레이니엄(Trainium)과 인페렌시아(Inferentia)를 지원해요.

AWS는 또한 아마존 베드락 사용자 정의 모델 가져오기(Amazon Bedrock Custom Model Import)를 통해 더 가벼운 버전인 딥시크-R1-디스틸(DeepSeek-R1-Distill)을 제공해요. 이 서버리스 배포는 확장성을 유지하면서 인프라 관리를 간소화해 준다고 해요.

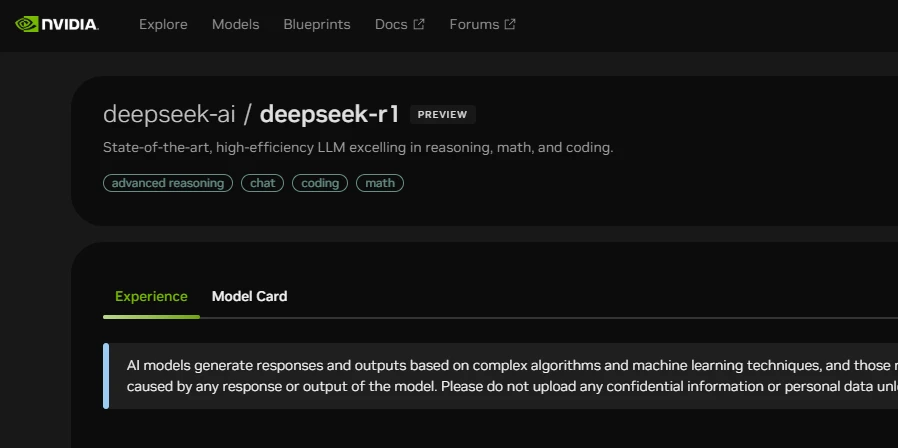

엔비디아 역시 호퍼(Hopper) 아키텍처와 FP8 트랜스포머 엔진 가속을 활용하여 실시간 고품질 응답을 제공하며 딥시크를 통합했어요.

6,710억 개의 파라미터와 128,000 토큰 컨텍스트 길이를 특징으로 하는 이 모델은 정확도 향상을 위해 테스트 시간 스케일링을 활용해요.

또한 엔비디아의 호퍼 아키텍처의 이점을 활용하여 FP8 트랜스포머 엔진 가속과 NVLink 연결을 사용해요. HGX H200 시스템에서 실행되는 딥시크-R1은 초당 최대 3,872개의 토큰을 생성할 수 있다고 해요.

마이크로소프트의 애저 AI 파운드리(Azure AI Foundry)와 깃허브는 개발자에게 AI를 워크플로에 통합할 수 있는 안전하고 확장 가능한 플랫폼을 제공하며 딥시크의 도달 범위를 넓혔어요.

마이크로소프트는 콘텐츠 필터링 및 자동 평가를 포함한 광범위한 안전 조치도 구현했어요. 마이크로소프트는 딥시크-R1의 디스틸 버전을 로컬 배포용으로 제공할 계획이라고 밝혔어요.

딥시크-R1은 강력하고 비용 효율적인 AI 모델과 고급 추론 기능을 제공하여 전 세계적으로 큰 인기를 얻었어요.

R1은 600만 달러의 비용으로 학습되었으며, 가장 진보된 버전은 엔비디아와 마이크로소프트의 유사 모델보다 학습 비용이 약 95% 저렴하다고 해요.